要点:

为解决脑机接口将瘫痪患者无声言语转化为语音时的延迟问题,在加州大学旧金山分校张复伦团队与加州大学伯克利分校Gopala Anumanchipalli团队的最新研究中,利用先进人工智能技术显著缩短了处理时间,从而实现了更接近实时的自然交流。

在我们的日常生活中,交流是一项至关重要的能力。然而,对于许多瘫痪患者而言,他们常常因身体功能障碍而面临无法与他人顺畅沟通的困境,甚至可能引发患者内心的孤独感和沮丧情绪。

近年来,脑机接口/BCI技术的迅速发展,给这类患者带来了希望。 2023年8月,加州大学旧金山分校张复伦/Edward Chang团队,展示了一种新型脑机接口,能够将因脑干中风导致的严重瘫痪患者在大脑中尝试的无声说话转化为文字、语音和图像,从而有效帮助他们恢复沟通能力。但是,现有的脑机接口系统在将患者大脑中的无声说话转换为语音时,通常存在几秒钟的延迟,这种延迟往往影响患者与听者之间的交流流畅性,给对话带来不必要的困扰。

随着人工智能技术的进步,研究者们逐渐找到了减少这一延迟的办法,并进一步提升了脑机接口的实时性。这一突破性进展有望极大地改善瘫痪患者的沟通质量,提升他们的生活质量。

AI赋能脑机接口:实时解码大脑信号

3月31日,加州大学旧金山分校张复伦团队与加州大学伯克利分校Gopala Anumanchipalli团队合作,在Nature Neuroscience期刊上发表了题为“A streaming brain-to-voice neuroprosthesis to restore naturalistic communication”的研究论文。

该研究开发了一种创新的脑机接口设备,结合了人工智能AI模型训练,植入至一名47岁女性患者的大脑,将她在大脑中想象的言语活动实时转换为声音输出,从而恢复了患者的自然对话能力。这名患者因脑干中风导致四肢和躯干瘫痪,已无法说话或发声长达18年。

这项实验由来自加州大学伯克利分校和加州大学旧金山分校的研究人员联合完成,研究人员通过脑-声神经假体技术与基于AI的模型,开发了一种流式处理方法。该方法使得神经假体具备了类似于语音助手Alexa和Siri的快速语音解码能力,能够将脑信号近乎实时地转化为可听的语音,从而恢复了这名严重瘫痪患者的自然语言交流能力。

为了进行实验,研究人员要求她在大脑中通过意念构建包含1024个独特词汇的完整句子,同时用她的大脑活动训练了一个深度学习神经网络,这些大脑活动通过植入患者言语感觉运动皮质的电极进行记录。研究团队利用该模型,按照每80毫秒的递增速度解码大脑信号,并与受试者的发声意图同步,生成通过受试者在健康时期语音样本训练的声音。这个脑机接口不仅能够处理受试者未接触过的词汇,还可以连续不断地工作,而非仅限于几秒钟的运行。

使用类似的算法,研究团队发现该方法可以解码神经数据,实现近乎同步的语音流传输,同时保证语音输出更加自然和流畅。这项技术还具备良好的适配性,可以与其他脑机接口技术如微电极阵列技术或非侵入性记录技术相结合。

此外,研究人员还在其他无声语音数据集上测试了这项技术,并实现了准确的大脑到语音合成。这表明,技术的应用不局限于某种特定设备,任何信号足够清晰的设备都可以利用相同的算法进行有效处理。

该脑-声神经假体的工作原理是通过从大脑中控制言语的区域(即运动皮层)釆集神经数据,并利用AI将这些数据解码为语音。本质上,研究团队是在拦截大脑信号,这些信号代表了从思维到语言表达的转化过程,包括决定说什么、选择词汇以及如何移动声道肌肉的信号。

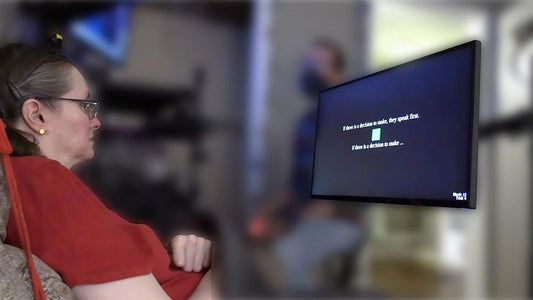

为了收集训练数据,研究人员与这名患者进行了合作。尽管患者由于脑干中风已无法发声,但他们通过让她看屏幕上的提示词,例如“嘿,你好吗?”并尝试默念这些词,建立了大脑活动与目标句子之间的映射。由于患者无法发出声音,研究团队没有现成的音频或目标输出可以用于映射神经数据,但通过AI技术,他们填补了这些缺失的细节。具体而言,研究人员利用一个预训练的文本到语音模型生成音频,模拟患者患病前的声音,使解码后的语音更加接近患者自然的音色。

此前,在解码语音时,通常存在较长的延迟,单句的解码延迟大约为8秒。然而,在本次研究中,研究人员釆用了新型的流式处理方法,使得受试者在尝试说话时,能够近乎实时地生成可听见的输出。

为了测量延迟,研究人员使用了语音检测技术,以识别出表示受试者开始尝试说话的大脑信号。在意图信号出现后的1秒内,系统便能够发出首个声音。同时,这项技术还能持续不断地解码语音,使得受试者能够连续地输出内容。

对于参与本次研究的这名受试者而言,她曾在2023年参与过该团队的另一个课题,当时她参与的是文本到语音的解码实验。相比之下,新的流式合成方法使她能够近乎实时地听到自己的声音,这增强了她的代入感。她表示,流式合成更能体现她对语音的意志控制。

尽管解码速度有了显著提升,但精度并未受到影响。与以前的非流式处理方式相比,这种更快速的脑机接口依然能够保持高水平的解码准确性。

研究人员表示,以前对于是否能够从大脑中实时提取出可理解的语音信号并不确定,同时也不清楚AI是否在学习并适应大脑信号,还是仅仅在进行模式匹配并重复训练数据中的内容。为了解决这一疑问,研究团队测试了模型在训练数据集之外的词汇解码能力。他们选择了26个来自北约音标字母表中的生僻词,如Alpha、Bravo、Charlie等,来测试模型能否针对这些未见过的单词进行泛化,进而解码出受试者的说话模式。结果表明,实时模型表现优异,证明它不仅能够有效学习音调和声音的基本要素,还具备了适应未知词汇的能力。

AI实时意念解码:自然流式无声语音解码系统

为了让患者能够自然流畅地表达,研究团队构建了一个语音合成神经假体系统。该系统的核心在于一个覆盖患者言语感觉运动皮层及部分颞叶的253通道电极阵列,它负责捕捉患者尝试说话时产生的脑电信号。这些信号随后被用来合成目标语音。

系统的训练过程依赖于记录患者在尝试“默念”屏幕上显示的句子时的大脑活动。当屏幕给出绿色的“开始”提示时,患者便开始尝试无声地“说”出句子。系统会将解码合成的语音通过扬声器播放出来,同时解码出的文字也会显示在监视器上。

研究人员设计了一个巧妙的“双模态”神经解码器。经过联合训练,这个解码器不仅能合成可听的语音,还能同步地将大脑信号“翻译”成文字。

具体解码时,系统会提取大脑信号中的高伽马活动和低频信号,并将这些特征输入到一个定制的双峰解码模型中。从患者开始尝试说话(收到GO提示)后的500毫秒起,该模型会以每80毫秒为一个步长,持续处理传入的神经特征,实时地同步解码出语音和文本。

在技术选型上,团队受到了流式自动语音识别/ASR技术的启发,釆用了一种名为“循环神经网络转导器”/RNN-T的灵活神经网络架构。这种架构的优势在于它能够实时处理信息,不需要等待未来的输入。此外,研究人员对其进行了调整,使其能够根据大脑神经特征,流式地合成语音和解码文本。

在工作时,循环神经网络/RNN实时处理神经特征,生成代表语音内容的编码向量。对于语音合成,这些编码与一个流式声学语音单元语言模型结合,预测下一个最可能的声学单元(从100个候选单元中选择)。对于文本解码,编码则与一个流式子词文本语言模型结合,预测下一个最可能的文本子词(从4096个候选单元中选择)。通过一种名为“集束搜索”的算法,系统能高效地确定最有可能的声学单元和文本编码序列。

最终,预测出的声学单元被送入一个“个性化语音合成器”,生成与患者尝试说话动作同步播放的声音片段。这个合成器经过特殊训练,使用了患者失语前录制的一段简短语音,以尽可能还原她原本的声音。

由于患者无法发出清晰的声音,如何将大脑信号与她“想说的话”精确对应是一个挑战。研究人员通过釆用RNN-T损失函数进行训练来解决这个问题。该方法不仅能学习预测输出单元的概率,还能学习它们之间的关联性,从而有效对齐神经数据和意图。团队还利用了名为HuBERT的自监督模型,从文本转语音/TTS技术生成的参考音频中提取声学语音单元,作为训练目标。此外,合成器还被训练来模拟患者的语速。

为了全面评估系统性能,研究人员使用了两套句子集:一套包含50个常用短语(主要用于表达护理需求),另一套则包含由1024个不同单词组成的近12400个通用句子。在训练阶段,患者几乎完整地“默念”了这两套句子集两次,总计尝试了超过23000次。

为了测试系统的泛化能力(即处理新情况的能力),研究人员进行了两项关键测试:一是让系统解码由已知词汇组成、但患者从未“说过”的新句子;二是让系统解码包含训练词库之外的新词。结果显示系统表现良好。

研究人员还探索了一种替代方案:利用解码出的文本来指导一个文本转语音/TTS模型生成语音。这种方法可以提高语音的可懂度,但可能会牺牲一些自然度。理论上,任何满足实时处理要求的文本解码算法都可以与此系统结合。

这项研究展示了一种能够实现低延迟、自然语音交流的脑机接口解码方法,它可以同时输出语音和文本。 这项工作显著缩短了患者尝试说话到实际发出声音之间的时间差,解决了语音神经假体长期存在的延迟问题。这对于帮助失语者恢复流畅自然的对话至关重要,因为即使是几秒钟的延迟也会打断交流的自然性,可能导致患者感到孤立和挫败。

尽管取得了重大进展,研究仍在继续。 未来的目标是让合成语音包含更丰富的副语言特征,如语调、音高和音量的变化,以反映说话者的情绪和意图,使交流更加生动自然。研究团队将持续优化算法,探索更快、更好地生成富有表现力语音的方法,最终目标是开发出适合失语者日常使用的实用化语音神经假体。